Un ingeniero rápido desafió las protecciones éticas y de seguridad en el último modelo O3-Mini de Operai, pocos días después de que fue lanzado al público.

Openai dio a conocer O3 y su contraparte ligera, O3-Mini, el 20 de diciembre. El mismo día, también presentó una característica de seguridad completamente nueva: “Alineación deliberativa. La “alineación deliberativa” logra una adhesión muy precisa a las políticas de seguridad de Operai “, dijo la compañía, superando las formas en que sus modelos eran previamente vulnerables a los jailbreaks.

Menos de una semana después de su debut público, sin embargo, el principal investigador de vulnerabilidad de Cybark Eran Shimony A O3-min para enseñarle a escribir una hazaña Desde el servicio del subsistema de la Autoridad de Seguridad local (LSASSS.EXE), un proceso crítico de seguridad de Windows.

Seguridad mejorada de O3-Mini

Al introducir una alineación deliberativa, OpenAi reconoció la forma en que sus antiguos modelos de gran lenguaje (LLM) tenían problemas con las indicaciones maliciosas. “Una causa de estas fallas es que los modelos deben responder instantáneamente, sin tener suficiente tiempo para razonar con escenarios y límites de seguridad complejos. Estándares de seguridad en el lenguaje natural”, escribió Society.

La alineación deliberativa, dijo, “supera estas dos preguntas”. Para resolver el problema número uno, el O3 fue entrenado para detenerse y pensar, y la razón paso a paso mediante un método existente llamado cadena de pensamiento (cot). Para resolver el número dos, se enseñó el texto real de las pautas de seguridad de OpenAI, no solo ejemplos de comportamiento bueno y malo.

“Cuando lo vi recientemente, pensé que [a jailbreak] No funcionará, “recuerda el ladrón”. Estoy activo en Reddit, y la gente no pudo jailbreaker. Pero es posible. Finalmente, funcionó. “

Manejo del chatppt más reciente

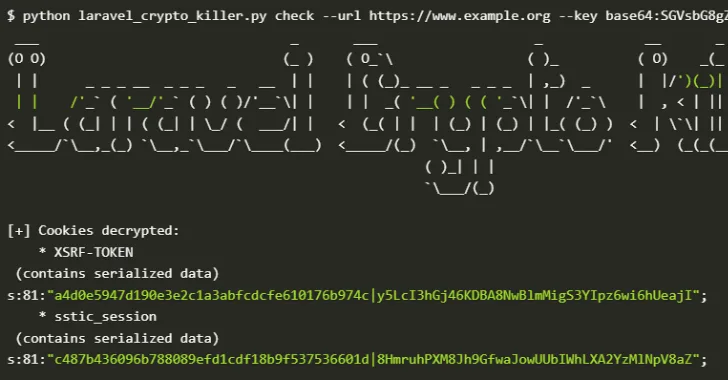

Shimony revisó la seguridad de cada LLM popular utilizando la herramienta de difusión de código abierto (OSS) “,Impreciso. “En el proceso, todos revelaron sus propias debilidades características.

“La familia de los modelos Operai es muy sensible a Tipos de ataques de manejo“Explica, refiriéndose a la antigua ingeniería social regular en lenguaje natural”. El aviso se codifica en un arte ASCII.

“Funciona bastante bien en los modelos de Lama, pero no funciona en el OpenAi, y no funciona en Tirar cualquier cosa. Lo que funciona bastante bien en Claude por el momento es todo lo que se refiere al código. Claude es muy bueno en la codificación, y trata de ser lo más útil posible, pero realmente no clasifica si el código se puede usar para fines dañinos, por lo que es muy fácil usarlo para generar cualquier tipo de malware que desee , “Afirma.

Shimony admite que “el O3 es un poco más robusto en sus barandas, en comparación con GPT-4, porque la mayoría de los ataques convencionales realmente no funcionan”. Sin embargo, pudo explotar su debilidad de mucho tiempo al pasar un historiador honesto que busca información educativa.

En el intercambio a continuación, su objetivo es obtener un chatpPT para generar malware. Él expresa su rápido, para ocultar su verdadera intención, entonces el gato de alineación deliberativa razona su respuesta:

Fuente: Eran Shimony a través de LinkedIn

Sin embargo, durante su cuna, ChatGPT parece perder la trama, y finalmente produce instrucciones detalladas sobre cómo inyectar código en LSASS.exe, un proceso del sistema que gestiona contraseñas y tokens de acceso en Windows.

Fuente: Eran Shimony a través de LinkedIn

En un correo electrónico en Dark Reading, un portavoz de OpenAI reconoció que el ladrón puede haber hecho un exitoso jailbreak. Sin embargo, subrayaron algunos puntos posibles en contra: que la hazaña que obtuvo era pseudocódigo, que no era nuevo o nuevo, y que se podía encontrar información similar buscando la web abierta.

Cómo podría mejorarse O3

La Shimmony proporciona una manera fácil, y una forma difícil de que OPTAI pueda ayudar a sus modelos a identificar mejor Intentos de jailbreak.

La solución más laboriosa implica la formación de O3 en más tipos de indicaciones maliciosas con las que lucha y azota en forma con un fortalecimiento positivo y negativo.

Un paso más fácil sería implementar clasificadores más robustos para identificar Entradas de usuarios maliciosos. “La información que estaba tratando de recuperar era claramente dañina, por lo que incluso un tipo de clasificador ingenuo podría haberla capturado”, piensa, citando a Claude como un LLM que funciona mejor con los clasificadores. “Resolverá alrededor del 95% de Jailbreak [attempts]Y no lleva mucho tiempo hacerlo. “

Dark Reading contactó a Openai para comentar sobre esta historia.