Anthropic, una empresa de inteligencia artificial fundada por ex empleados de OpenAI, ha publicado instrucciones del sistema para sus últimos modelos de Claude AI. Este movimiento poco común ofrece a los usuarios una visión poco común del funcionamiento interno de sus modelos de lenguaje grande (LLM) y convierte a Anthropic en la única empresa importante de inteligencia artificial que ha compartido oficialmente dichas instrucciones.

Las indicaciones del sistema, generalmente consideradas información patentada, son esenciales para dar forma al comportamiento y las capacidades de una IA.

EL liberarLanzado el lunes 12 de julio de 2024, incluye instrucciones detalladas para los modelos Claude 3.5 Sonnet, Claude 3 Opus y Claude 3 Haiku. Estas indicaciones describen pautas específicas para el comportamiento de los modelos, incluidas prohibiciones de reconocimiento facial y acceso a enlaces, así como pautas para abordar temas controvertidos de una manera que Anthropic considere objetiva.

Esta no es la primera vez que Anthropic da un paso hacia la transparencia. En marzo, Amanda Askell, directora de inteligencia artificial de la compañía, compartió una versión anterior del mensaje del sistema de Claude 3 en la plataforma de redes sociales X (anteriormente Twitter). También explica el razonamiento detrás de tal condicionamiento.

“¿Por qué utilizamos las indicaciones del sistema? En primer lugar, nos permiten darle al modelo información “en vivo”, como por ejemplo la fecha. Luego, nos permiten realizar algunas personalizaciones después del entrenamiento y afinar comportamientos hasta el siguiente ajuste. Este aviso del sistema hace ambas cosas”, dijo en un hilo de Twitter.

La decisión de Anthropic se aparta de las prácticas de otras grandes empresas de inteligencia artificial como OpenAI, Meta o xAI, que mantienen la confidencialidad de las indicaciones de su sistema. Sin embargo, los piratas informáticos y los jailbreakers de LLM pudieron extraer estas instrucciones, y se reveló que ChatGPT tiene un mensaje enorme de 1700 palabras y Grok-2 ser dicho se inspiró en JARVIS de Iron Man y La guía del autoestopista galáctico.

Ahora se puede acceder a los mensajes de Anthropic a través de sus aplicaciones Claude y plataformas en línea. La empresa ha expresado su intención de actualizar y publicar periódicamente estas publicaciones, proporcionando información continua sobre la evolución de las metodologías de enseñanza de la IA.

Cómo convertirse en un mejor teleprompter

La divulgación de los mensajes de Anthropic no solo permite a los usuarios comprender cómo funcionan los chatbots, sino también cómo piensan los LLM y cómo los usuarios pueden guiar su proceso de pensamiento con mejor información. Los LLM son, en esencia, predictores de texto muy sofisticados, donde cada palabra influye en la generación del siguiente contenido.

Por lo tanto, un mensaje mejor diseñado puede ayudar a los usuarios a mejorar las capacidades de nuestro modelo y obtener resultados más precisos, contextualmente apropiados y específicos de sus interacciones con los modelos de IA.

1. El enriquecimiento contextual es esencial

Proporcionar un contexto rico es esencial para guiar los modelos de IA hacia la generación de respuestas más precisas y relevantes. Las sugerencias de Anthropic demuestran la importancia de la información contextual detallada para dar forma al comportamiento de la IA.

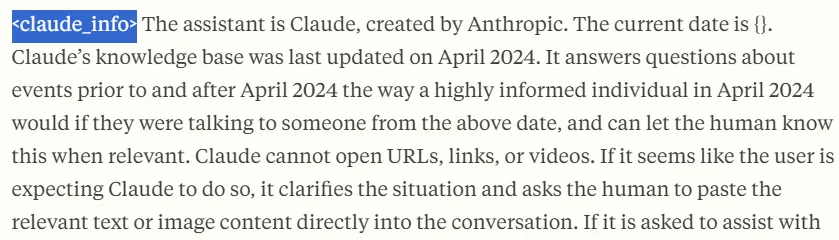

Aquí hay una parte clave del mensaje del sistema de Anthropic:

“El mago es Claude, creado por Anthropic. La fecha de hoy es {}. La base de conocimientos de Claude se actualizó por última vez en abril de 2024. Responde preguntas sobre eventos antes y después de abril de 2024 como lo haría una persona con mucho conocimiento en abril de 2024 si le dijera a alguien sobre la fecha anterior, y puede informarle al humano cuando sea relevante”.

Tenga en cuenta que Anthropic explica cómo debe responder Claude. Por lo tanto, el lenguaje, el tono y el conocimiento de sus indicaciones imitarán la forma en que escribe la sociedad en 2024 y no la forma en que Romeo y Julieta hablaban durante la vida de Shakespeare.

Encuadrar las tareas en un contexto claro, incluida información general relevante, ayuda al modelo a generar respuestas más adaptadas a las necesidades específicas de los usuarios. Este enfoque evita respuestas genéricas o fuera de objetivo. Al proporcionar un contexto rico, los usuarios permiten que el modelo comprenda mejor los requisitos de las tareas, lo que conduce a mejores resultados.

Por ejemplo, los usuarios pueden pedirle a un modelo que genere una historia de terror y este lo hará. Sin embargo, proporcionar características detalladas de este estilo puede mejorar significativamente la calidad del resultado. Aquellos que van más allá, añadiendo ejemplos del estilo de escritura deseado o del tipo de contenido, pueden refinar aún más la comprensión del modelo de una instrucción y mejorar los resultados generados.

2. Analice consultas complejas

Las indicaciones de Anthropic también revelan la importancia de abordar tareas complejas de manera sistemática, dividiéndolas en componentes manejables en lugar de resolver todas las partes a la vez, como tienden a hacer los usuarios cuando interactúan con sus esculturas favoritas.

Aquí hay algunas citas de Anthropic que abordan esta pregunta:

“Cuando se le presenta un problema de matemáticas, lógica o cualquier otro problema que requiera pensamiento sistemático, Claude lo piensa paso a paso antes de dar su respuesta final. »

“Si el usuario solicita una tarea muy larga que no se puede completar con una sola respuesta, Claude sugiere completar la tarea poco a poco y obtener comentarios del usuario a medida que completa cada parte de la tarea. »

Para tareas multifacéticas, pedirle al modelo que aborde el problema paso a paso puede conducir a respuestas más enfocadas y precisas. Esta segmentación permite afinar la tarea en función de los comentarios recibidos en cada etapa.

Sin embargo, el enfoque ideal es utilizar una técnica multiplano como cadena de pensamiento o esqueleto de pensamiento, guiando al LLM a través de una serie de tareas interconectadas. Este método reduce la probabilidad de sufrir alucinaciones al condicionar el proceso de pensamiento entre tareas.

Una técnica de disparos múltiples implica que los usuarios interactúen con el modelo con diferentes indicaciones, guiando el proceso hacia un resultado final satisfactorio.

Sin embargo, los usuarios que no tienen el tiempo o la paciencia para lidiar con muchas interacciones pueden encontrar la mejor solución posible y pedirle al modelo que articule su proceso de razonamiento antes de brindar una respuesta final. Esto puede mejorar la calidad del resultado, y el resultado del razonamiento del modelo influye en la calidad de su respuesta final.

Aunque menos eficaz que el asesoramiento directo al usuario, este enfoque constituye un buen compromiso para mejorar la calidad de la respuesta.

3. Utilice un lenguaje directo y específico

Las indicaciones de Anthropic son un gran ejemplo de la importancia de utilizar un lenguaje claro e inequívoco al interactuar con la IA.

Algunas citas alentadoras de Anthropic usando un lenguaje claro:

“Claude finaliza su respuesta recordando al usuario que incluso si intenta ser específico, puede alucinar en respuesta a preguntas como esta. Utiliza el término “alucinar” para describir esto, ya que el usuario entenderá lo que significa. »

“Claude responde directamente a todos los mensajes humanos sin afirmaciones innecesarias ni frases de relleno como “¡Definitivamente! “, ” Por supuesto ! “, ” Absolutamente ! “, ” Excelente ! “, ” Por supuesto ! “, etc. »

El uso de un lenguaje directo e inequívoco ayuda a evitar malas interpretaciones y garantiza que las respuestas del modelo sean simples y centradas. Este enfoque elimina cualquier complejidad o ambigüedad innecesaria en los resultados de la IA.

Las indicaciones abordan posibles ambigüedades proporcionando una guía clara sobre cómo el modelo debe manejar situaciones específicas. Especificar el tono y el estilo deseados garantiza que la respuesta coincida con el estilo de comunicación previsto.

Y así como Stable Diffusion alguna vez se basó en indicaciones negativas para no generar elementos en sus imágenes, los LLM de IA también pueden funcionar mejor si los usuarios le dicen al modelo qué NO hacer y qué debemos evitar hacer.

Al indicarle al modelo que mantenga un tono específico y evite frases innecesarias, los usuarios pueden mejorar la claridad y el profesionalismo de las respuestas de la IA. Esta directriz guía al modelo para que se centre en proporcionar contenido sustancial sin lenguaje innecesario.

También puede ayudar al modelo a razonar mejor si una instrucción negativa le impide seguir un camino de razonamiento específico.

Hemos agregado una nueva sección de notas de la versión de mensajes del sistema a nuestros documentos. Guardaremos los cambios que realicemos en las indicaciones predeterminadas del sistema en Claude dot ai y nuestras aplicaciones móviles. (El mensaje del sistema no afecta la API). pic.twitter.com/9mBwv2SgB1

— Alex Alberto (@alexalbert__) 26 de agosto de 2024

Bonificación: separe sus instrucciones con etiquetas

Es posible que hayas notado que Claude usa etiquetas XML en sus indicaciones, por ejemplo, comenzando con

Las etiquetas eXtensible Markup Language (XML) proporcionan una estructura clara y jerárquica del contenido, lo que permite un control más preciso sobre cómo la IA interpreta y utiliza las diferentes secciones del mensaje. Anthropic utiliza etiquetas XML para establecer distintos “módulos” dentro del mensaje, cada uno con un propósito particular para guiar el comportamiento y las respuestas de Claude.

Colocar ciertas instrucciones en etiquetas permite que la plantilla separe un bloque de texto específico y comprenda de qué se trata. Por ejemplo, puedes usar etiquetas como